PFNは自社が持つ計算基盤や最先端技術を応用し、各業界のドメイン知識をかけ合わせたAIソリューションや製品を様々な業界向けに提供しています。

計算可能なものづくりでより効率よく、安全に、低環境負荷に

革新的でサステナブルな新素材の開発を計算機とAIの力で飛躍的に高速化

計算機科学の力で新薬開発をより速く 最適な健康管理法や病気の発見をより早く

AI技術の活用で人間の創造性を解き放ち これまでになかった新しい表現・体験を可能に

AIとロボットで小売・流通の現場を さらに自動化・効率化

最先端のAI技術・研究成果を 金融領域の複雑な課題解決にいち早く適用

人々の文化や生活を守る社会のインフラを AI技術でアップデート

コンピュータサイエンスを学んで 自動化・プログラミングをもっと楽しく

生成AIを駆使して多様なビジネス現場の課題解決を支援

2025.12.02

PFNのPLaMo翻訳、ガバメントAI「源内」で利用開始

2025.10.07

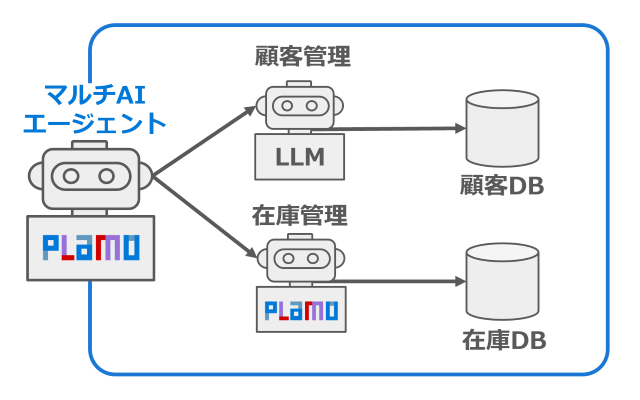

エージェント機能が大幅に強化されたPLaMo 2.1 Primeの提供開始ソフトウェア、ハードウェア、そして各分野の専門知識を高度に融合できるチームが私たちの強みです。

ソフトウェア、ハードウェア、そして各分野の専門知識を高度に融合できるチームが私たちの強みです。

コンピュータの力で世界をより良くしたい、圧倒的に便利で安心な世の中を実現したい、それが、私たちの想いです。

コンピュータの力で世界をより良くしたい、圧倒的に便利で安心な世の中を実現したい、それが、私たちの想いです。